文章标题

robots文件详解

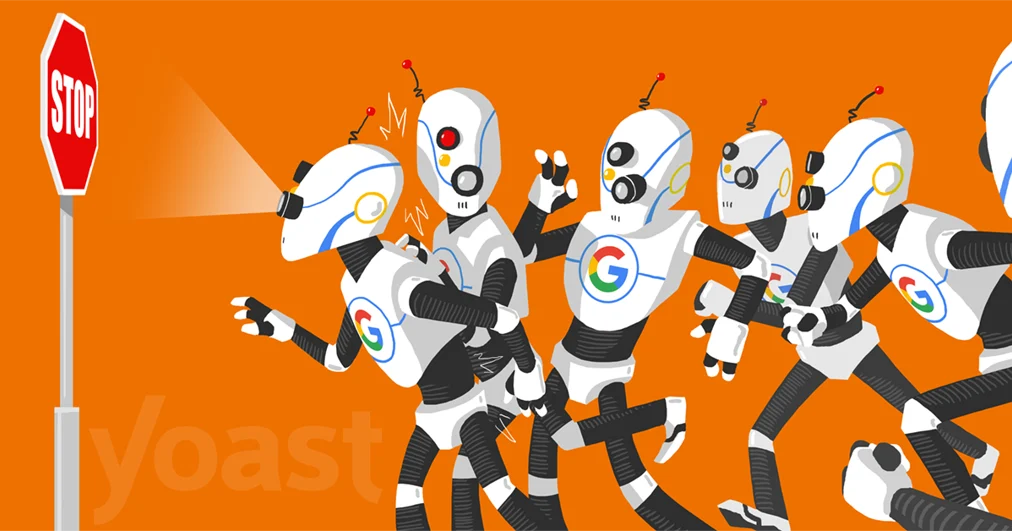

在互联网的世界里,有一个小小的、但却极为重要的文件,那就是robots文件。本文将为您详细解读robots文件的含义、作用及如何利用它来提升网站用户体验。

一、什么是robots文件?

robots文件(通常名为robots.txt)是一个存在于网站根目录的纯文本文件,它提供了网站管理者希望搜索爬虫(搜索引擎)如何索引自己网站信息的规则。该文件能够告知搜索引擎哪些区域需要抓取和哪些区域不应抓取,这样搜索引擎爬虫就能根据这些规则来决定如何访问和索引网站。

二、robots文件的作用

-

控制搜索引擎抓取范围:通过

robots文件,网站管理员可以控制搜索引擎对网站的访问权限,避免敏感或未完成的内容被搜索引擎抓取。 -

提升用户体验:通过合理设置

robots文件,可以避免重复或错误的页面被搜索引擎索引,从而保证搜索结果的准确性和用户体验。 -

保护网站资源:对于资源有限的网站,

robots文件可以控制爬虫的访问频率,避免过度抓取对服务器造成过大压力。

三、如何编写robots文件?

一个基本的robots.txt文件只包含一条或多条用户-主体指令对,其基本语法格式如下:

User-agent: * # 指定用户代理(即搜索引擎爬虫)的名称或类型。星号(*)表示所有爬虫。

Disallow: /path/to/file # 禁止访问的文件路径或目录路径。以“Disallow”开始表示不允许访问该行下的URL或路径。反之,“Allow”表示允许访问的URL或路径。如果没有任何其他路径在文件中被允许,那么“Disallow”行默认会禁止所有路径的访问。例如:

User-agent: *

Disallow: /private/ # 禁止爬虫访问私有的网站部分(假设有“/private/”目录)

Allow: /public/ # 允许爬虫访问公开的网站部分(如博客主页)如果只需要限制几个特定的爬虫,也可以明确指出它们,而不必使用通配符*:

User-agent: Baidu-Spider # 仅对百度爬虫有效

Disallow: /api/ # 禁止百度爬虫访问api相关内容四、注意事项

-

简洁明了:

robots文件应简洁明了,避免使用复杂的语法和规则。每个指令应清晰表达其意图。 -

测试:在修改了

robots文件后,应通过搜索引擎的抓取工具或网站日志来检查是否生效,并确保没有误禁重要的页面或资源。 -

定期更新:随着网站的发展和变化,

robots文件可能需要不断更新以适应新的需求和情况。保持定期更新可以确保网站的SEO效果始终保持最佳状态。

以上就是关于robots文件的详细解读与使用指南。通过了解并正确使用robots文件,我们可以更好地控制搜索引擎对网站的访问和抓取,从而提升用户体验和网站的SEO效果。

Label:

- **关键词:robots文件

- 搜索引擎

- 用户体验

- 控制抓取范围

- robots.txt

- 用户-agent

- Disallow

- Allow

- SEO效果**