hdfs是什么

文章标题:HDFS是什么?

内容:

在大数据技术中,HDFS是一种非常重要的分布式文件系统,它为大规模数据存储提供了高可靠性、高扩展性和高容错性的解决方案。那么,HDFS究竟是什么呢?

一、HDFS的定义

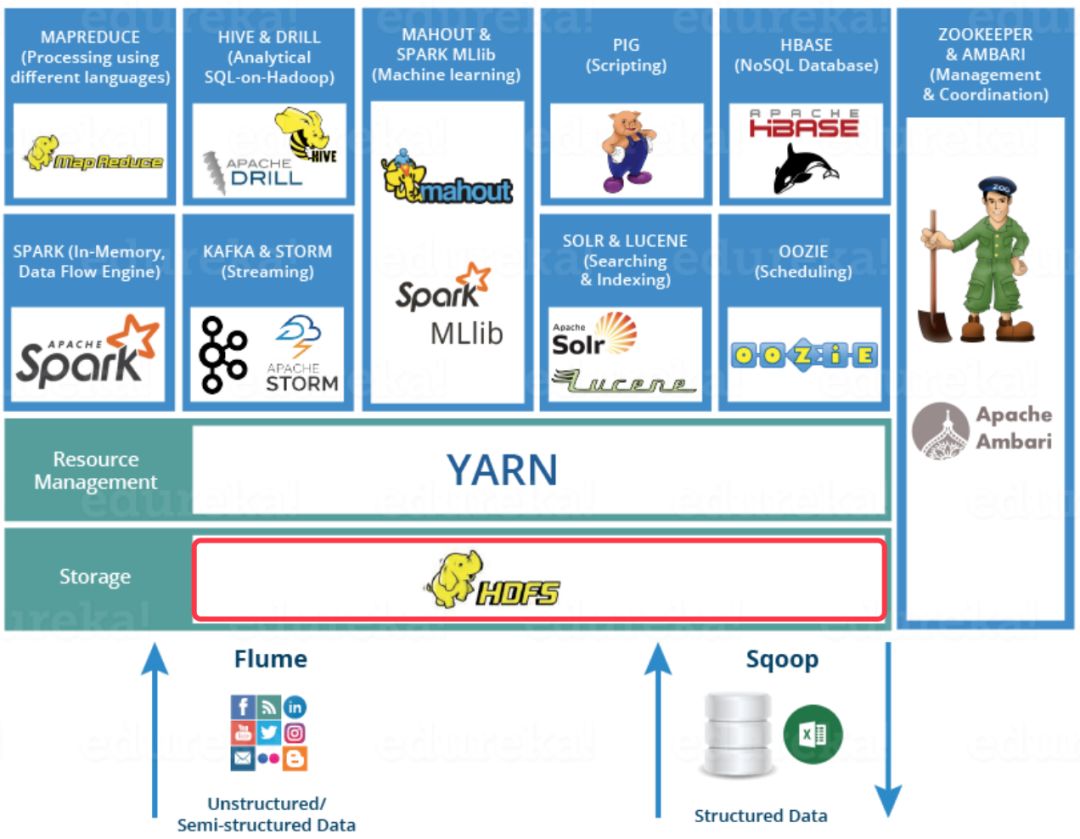

HDFS(Hadoop Distributed File System)是Hadoop生态系统中的一个核心组件,它是一个分布式文件系统,设计用来部署在低成本的硬件上。HDFS允许将一个非常大的文件分割成多个小文件进行存储,并且这些文件可以被部署在多个服务器上,这样就能保证数据的可靠性和容错性。

二、HDFS的特点

- 高容错性:HDFS的设计非常重视数据的可靠性和容错性。数据会以副本的形式保存在多个服务器上,当某些服务器发生故障时,数据不会丢失。

- 大规模数据处理:HDFS非常适合处理大规模的数据集,可以处理PB级别的数据。

- 简单一致性:HDFS的设计简单一致,使得它易于理解和使用。

- 成本低廉:HDFS可以部署在低成本的硬件上,大大降低了大数据处理的成本。

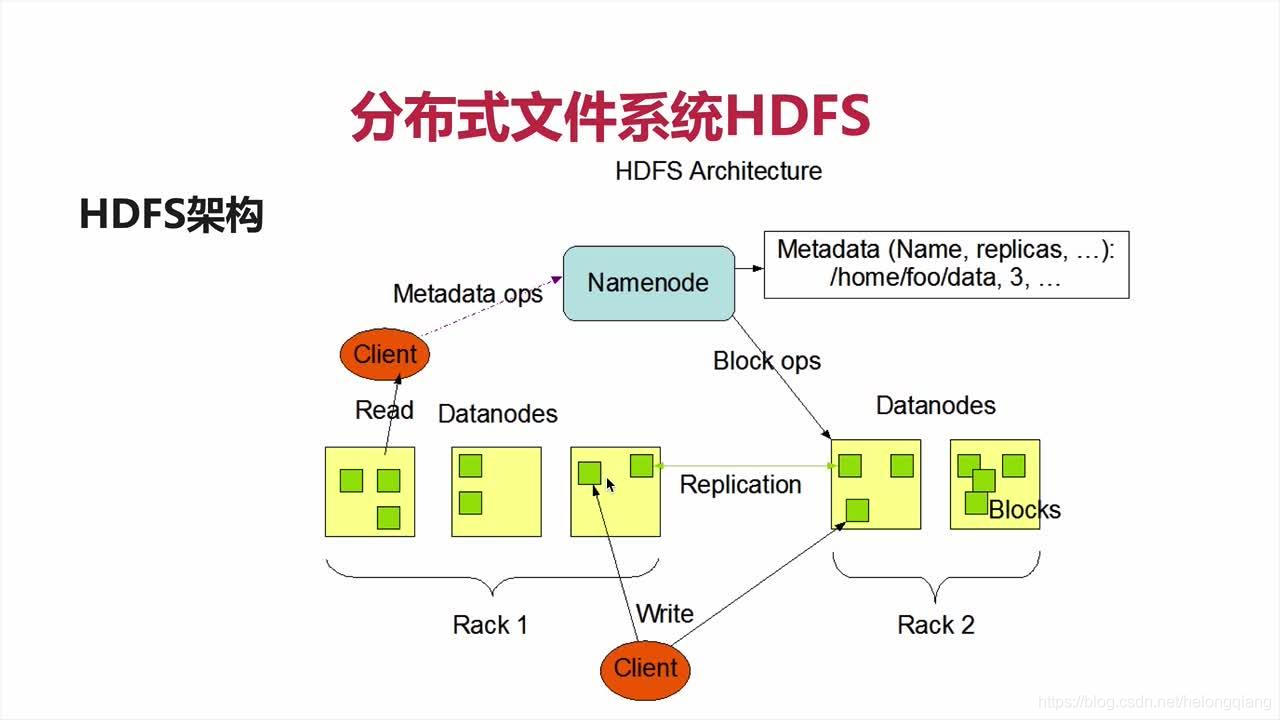

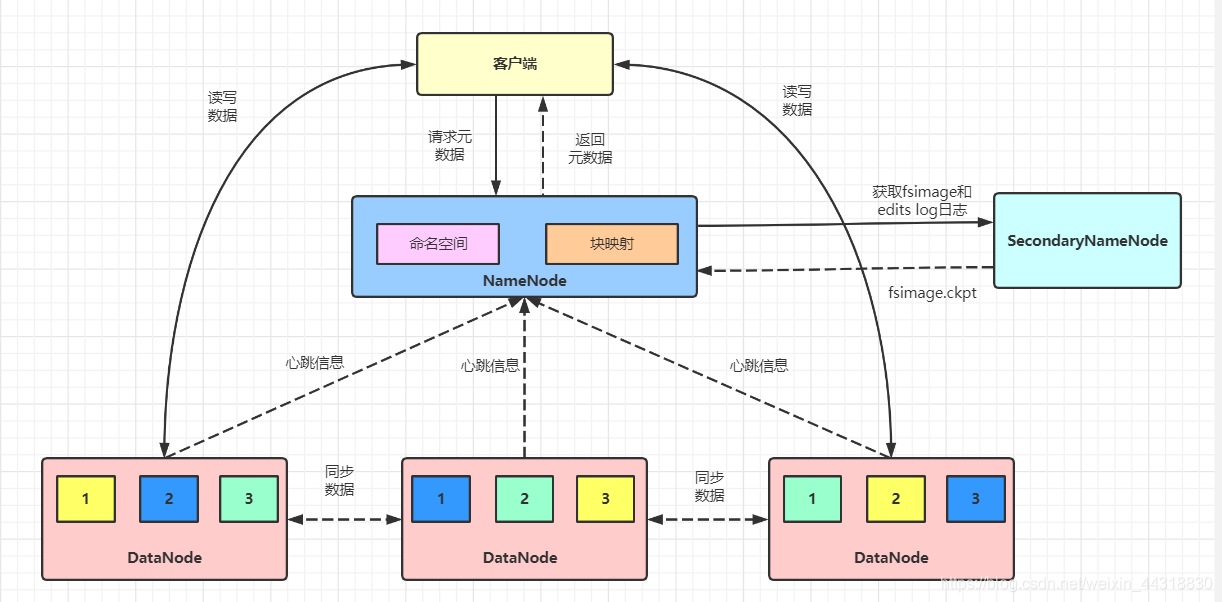

三、HDFS的架构

HDFS的架构主要包含两个部分:NameNode和DataNode。NameNode是整个文件系统的管理者,负责管理文件系统的元数据;而DataNode则是实际存储数据的节点。当客户端需要读取或写入数据时,会通过NameNode来找到正确的DataNode进行操作。

四、HDFS的应用场景

由于HDFS具有高可靠性、高扩展性和高容错性的特点,因此它在许多领域都有着广泛的应用,比如搜索引擎的索引数据存储、大数据处理和机器学习等领域。它允许开发者们在云端构建可靠的数据处理和存储环境。

以上就是关于HDFS的基本介绍。HDFS作为一个重要的分布式文件系统,为大数据处理提供了强大的支持,是现代大数据技术中不可或缺的一部分。