什么是决策树

一、文章标题

什么是决策树?

二、文章内容

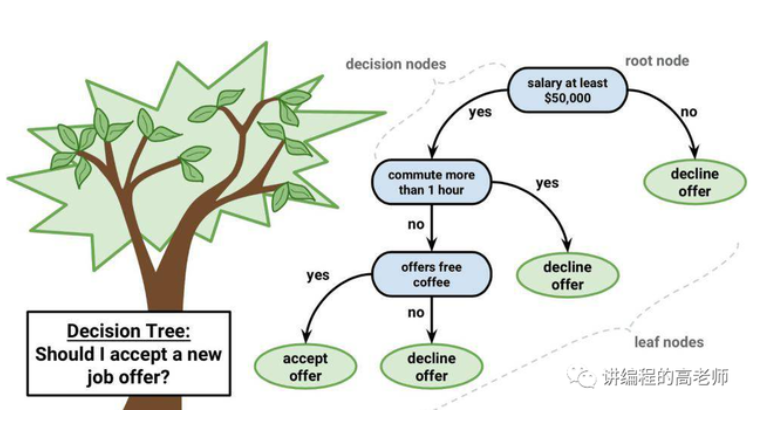

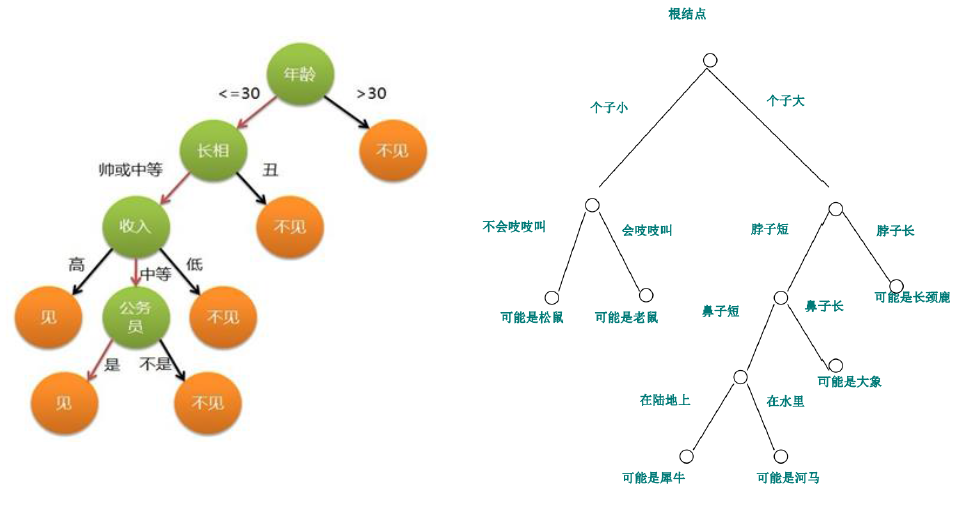

在机器学习和数据分析领域,决策树是一种常用的监督学习方法。它通过构建树状结构,将数据集进行分类或回归。决策树模型易于理解和解释,能够清晰地展示出数据的分类过程,因此被广泛应用于各种领域。

1. 决策树的基本概念

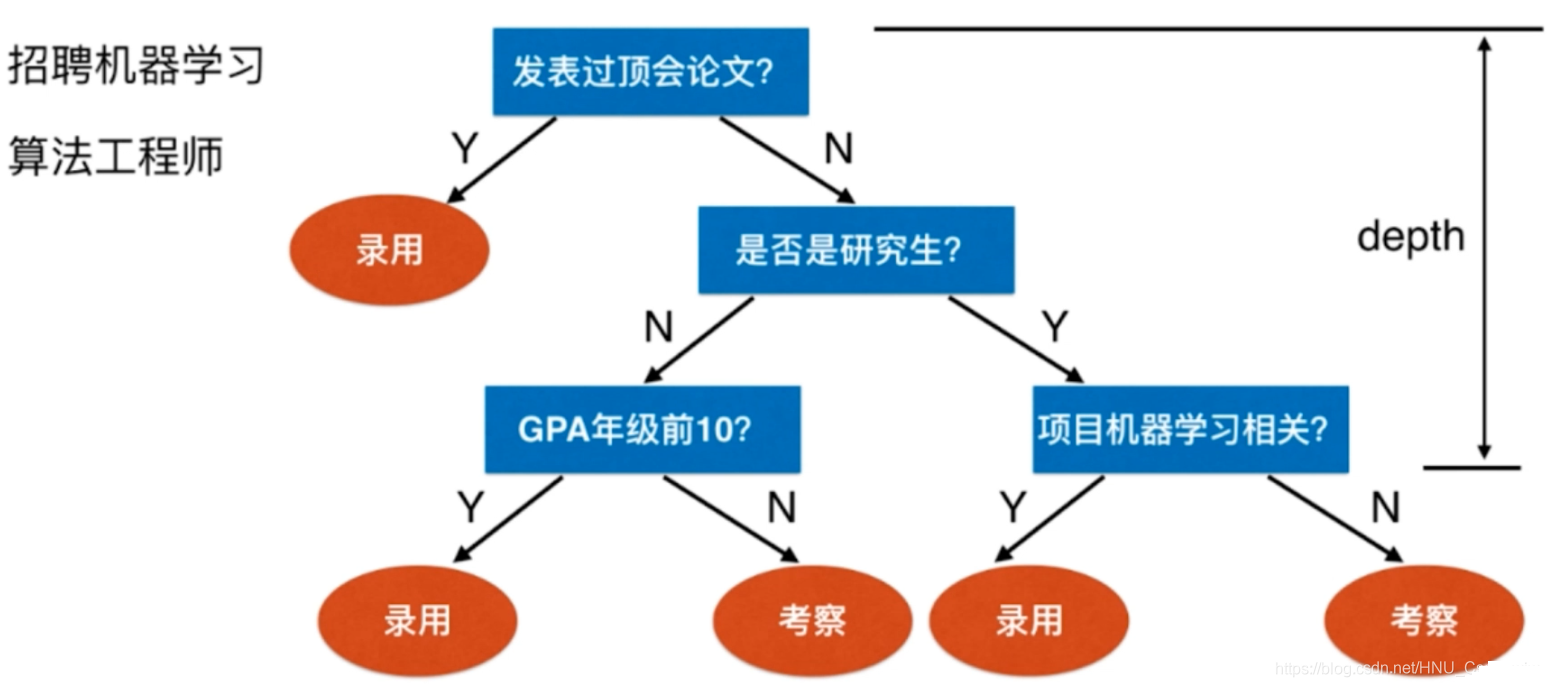

决策树主要由根节点、中间节点、叶节点构成。根节点是整个树的起点,通常对应于数据集中的某个特征或属性。中间节点则是根据某个特征或属性的值进行分类的过程,而叶节点则表示最终的分类结果。

2. 决策树的构建过程

决策树的构建过程通常包括三个步骤:特征选择、决策树的生成和决策树的剪枝。

- 特征选择:这是决策树构建的第一步,主要是选择哪个特征或属性作为根节点。选择的标准通常是信息增益、增益率、基尼指数等。

- 决策树的生成:根据选定的特征或属性,将数据集划分为子集,然后递归地在每个子集上选择最优的特征或属性,生成新的决策树。

- 决策树的剪枝:为了防止过拟合,需要对决策树进行剪枝,即删除一些分支或叶子节点,以简化模型并提高泛化能力。

3. 决策树的应用场景

决策树的应用非常广泛,可以用于分类问题、回归问题、预测问题等。在金融、医疗、教育等领域都有广泛的应用。例如,在金融领域,可以用决策树进行信用评分、股票预测等;在医疗领域,可以用决策树进行疾病诊断、药物选择等;在教育领域,可以用决策树进行学生成绩预测、课程推荐等。

4. 决策树的优缺点

- 优点:易于理解和解释,可视化效果好,能够处理数值和离散数据,不需要大量的预处理等。

- 缺点:对某些数据的处理效果可能不佳,容易过拟合,对噪声数据敏感等。

总之,决策树是一种非常有用的机器学习算法,它能够通过构建树状结构对数据进行分类或回归。在实际应用中,我们需要根据具体的问题和数据集来选择是否使用决策树算法。