robots协议

主机域名文章

2025-03-19 01:45

257

文章标题:robots协议

在互联网时代,网站的流量、爬虫和搜索引擎的优化(SEO)成为了许多网站所有者和开发者的关注焦点。其中,robots协议(也称为“robots.txt”协议)是网站管理工具之一,用于控制网站在搜索引擎中的访问权限。本文将详细介绍什么是robots协议、其作用和如何正确使用。

一、什么是robots协议?

Robots协议,即“robots.txt”协议,是一种基于robots.txt文件对网站访问权限进行管理的协议。这个文件以纯文本形式存储在网站的根目录下,通过其中的规则和指令来告诉爬虫(即搜索引擎的蜘蛛程序)哪些页面可以访问,哪些页面禁止访问。

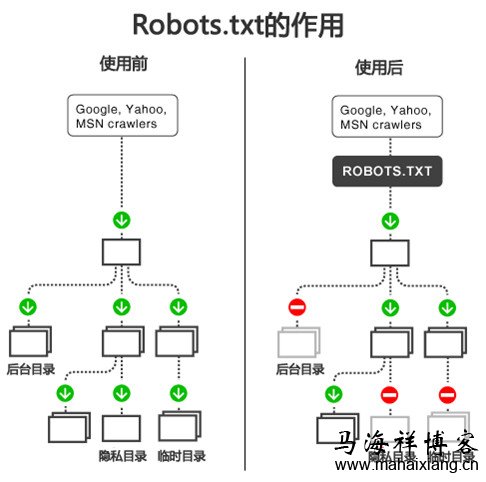

二、robots协议的作用

- 保护网站安全:防止未经授权的爬虫对网站进行恶意访问或攻击。

- 优化搜索引擎:通过合理设置robots协议,使搜索引擎能够更高效地抓取和索引网站内容,提高网站的搜索排名。

- 提升用户体验:避免网站被过度爬取而导致的性能问题,保证用户能够快速访问网站。

三、如何正确使用robots协议?

- 创建robots.txt文件:在网站的根目录下创建一个名为“robots.txt”的文件。

- 定义规则:在文件中定义对爬虫的访问规则,如允许或禁止某些目录或文件的访问。规则通常使用简单的正则表达式语法。

- 明确说明:在文件中明确说明网站对爬虫的访问策略,以及违反协议的后果。

- 定期更新:随着网站的发展和需求变化,定期更新robots.txt文件中的规则。

四、常见使用场景

- 保护敏感信息:对于包含敏感信息的页面,如用户个人信息、内部资料等,可以通过robots协议禁止爬虫访问。

- 限制访问频率:对于频繁被爬取的页面或API接口,可以通过设置访问频率限制来避免资源浪费。

- 公开网站内容:对于希望被搜索引擎抓取和索引的页面,可以通过允许爬虫访问来提高网站的搜索排名。

五、注意事项

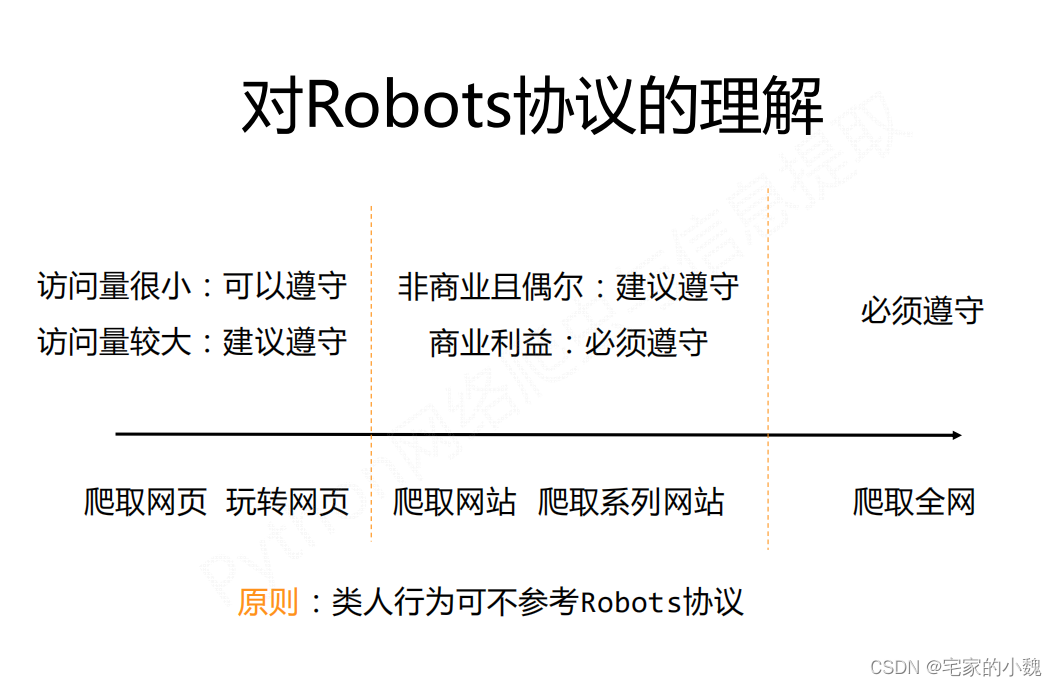

- 遵守规则:遵守互联网相关的法律法规和搜索引擎的规定,不违反robots协议。

- 兼容性:考虑不同搜索引擎的兼容性,确保您的robots.txt文件能够在各种搜索引擎中正常工作。

- 定期检查:定期检查您的robots.txt文件是否仍然有效,并根据需要进行更新和调整。

总结:Robots协议是网站管理的重要工具之一,通过合理设置和使用robots.txt文件,可以保护网站安全、优化搜索引擎和提高用户体验。在使用过程中,需要遵守相关法律法规和搜索引擎的规定,确保文件的正确性和有效性。

标签:

- 五个关键词: robots协议

- robots.txt文件

- 网站管理

- 搜索引擎优化

- 访问权限