决策树是什么

决策树是什么?

一、简介

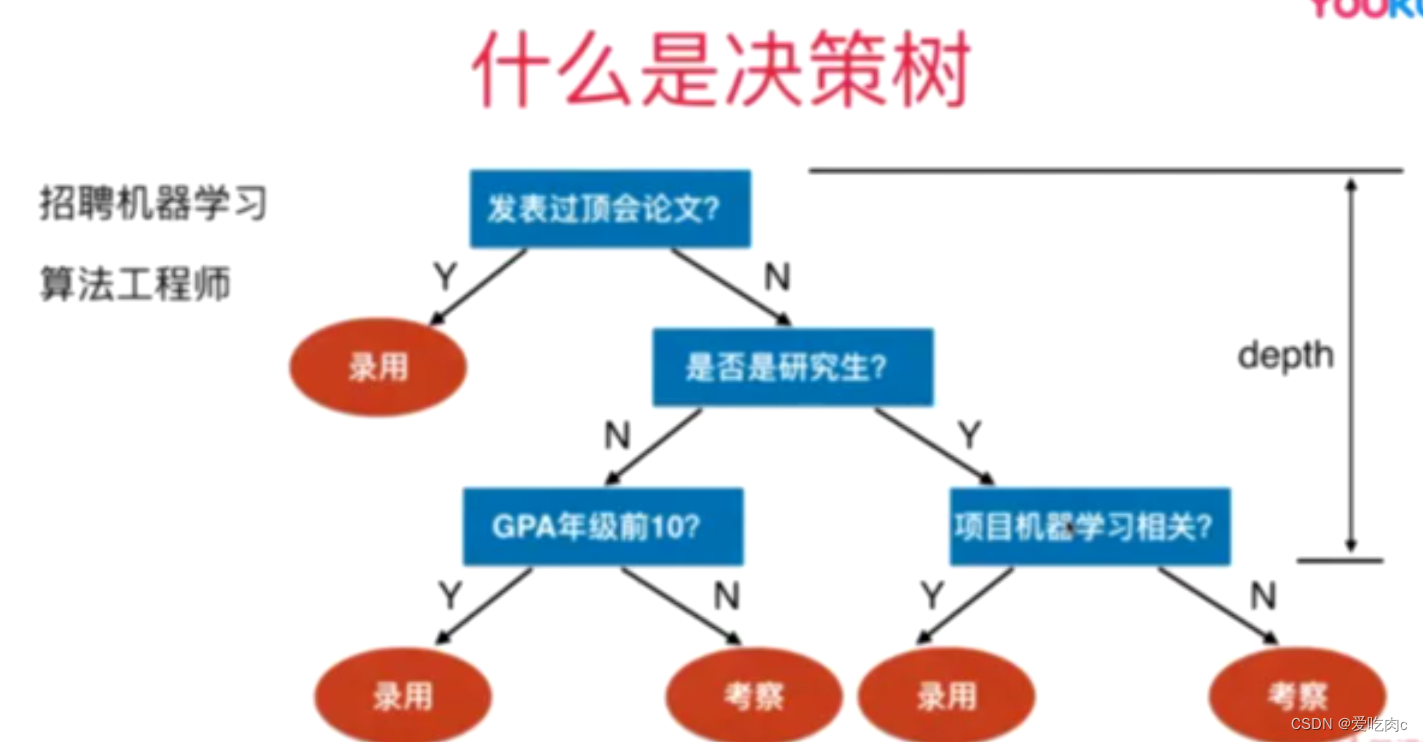

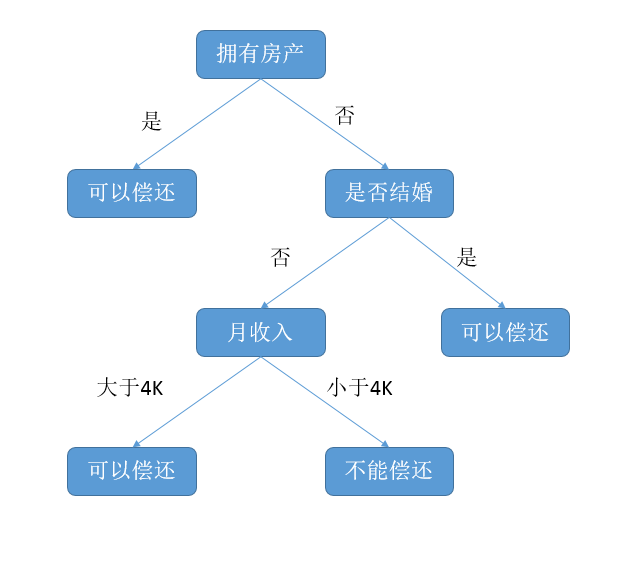

决策树,英文为"Decision Tree",是机器学习中的一种非参数监督学习方法,广泛应用于分类和回归问题中。它的思想类似于我们日常生活中所做的决策过程,即根据不同的条件,进行判断、选择,最终得出结论。

二、决策树的基本构成

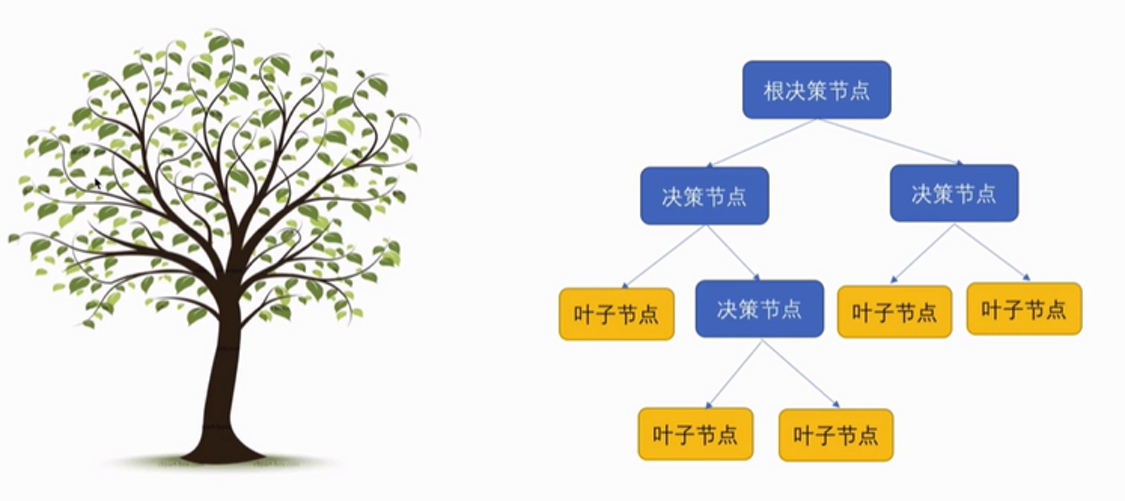

决策树主要由根节点、内部节点、叶节点等构成。根节点是整个树的入口,代表我们要解决的所有问题。内部节点表示在决策过程中的一个判断条件或一个特征属性。叶节点则表示最终的决策结果或类别。

三、决策树的生成过程

- 数据准备:首先需要准备一组带有标签的数据集,用于训练决策树模型。

- 特征选择:从数据集中选择一个最具有分类能力的特征作为根节点或内部节点的判断条件。这个过程通常基于某种算法(如信息增益、基尼指数等)。

- 递归构建:根据选定的特征对数据进行分割,然后对每个子集递归地构建决策树。直到满足停止条件(如所有子集都属于同一类别、树深度达到预设值等)。

- 生成叶节点:当递归到不能再分时,将最后一个子集的标签作为叶节点的类别标签。

四、决策树的应用

决策树的应用非常广泛,可以用于分类问题(如垃圾邮件识别、疾病诊断等),也可以用于回归问题(如房价预测、股票价格预测等)。此外,决策树还可以用于可视化复杂的数据关系,帮助人们更好地理解数据。

五、决策树的优点与缺点

优点:

- 直观易懂:决策树的结构清晰,易于理解。

- 计算效率高:对于数值型和标称型数据都适用。

- 无需复杂的预处理:相对于其他算法,决策树对数据的预处理要求较低。

缺点:

- 过拟合:决策树容易过拟合,尤其是在数据集噪声较多时。

- 不稳定:微小的数据变动可能导致树的巨大变化。

- 处理非线性问题能力有限:对于复杂、非线性的关系,决策树的表达能力可能不足。

总之,决策树是一种简单而有效的机器学习方法,广泛应用于各个领域。通过理解其基本原理和构成,我们可以更好地应用它来解决实际问题。