爬数据

一、爬数据的简介

在互联网信息时代,数据的获取变得至关重要。为了快速、有效地从网络上抓取数据,爬虫技术应运而生。而"爬数据",也被通俗地称为网络爬虫或者爬虫,主要是利用网络协议来自动化获取信息的一种方法。本文主要讲述关于爬数据的意义、用途、技术和可能面临的挑战和解决方法。

二、为何需要爬数据?

首先,数据是决策的基石。在大数据时代,我们常常需要大量、实时的数据来辅助决策。无论是企业进行市场分析,还是个人进行日常的搜索浏览,都离不开数据的支持。其次,通过爬取数据,我们可以更好地了解互联网的结构和内容,从而更有效地进行信息检索和数据分析。

三、爬数据的用途

- 搜索引擎:搜索引擎通过爬虫技术来抓取网页信息,并按照一定的算法进行排序和展示。

- 数据分析:企业和研究机构通过爬取公开的网站数据,进行市场分析、趋势预测等。

- 学术研究:学者们通过爬取学术网站的数据,进行学术研究和分析。

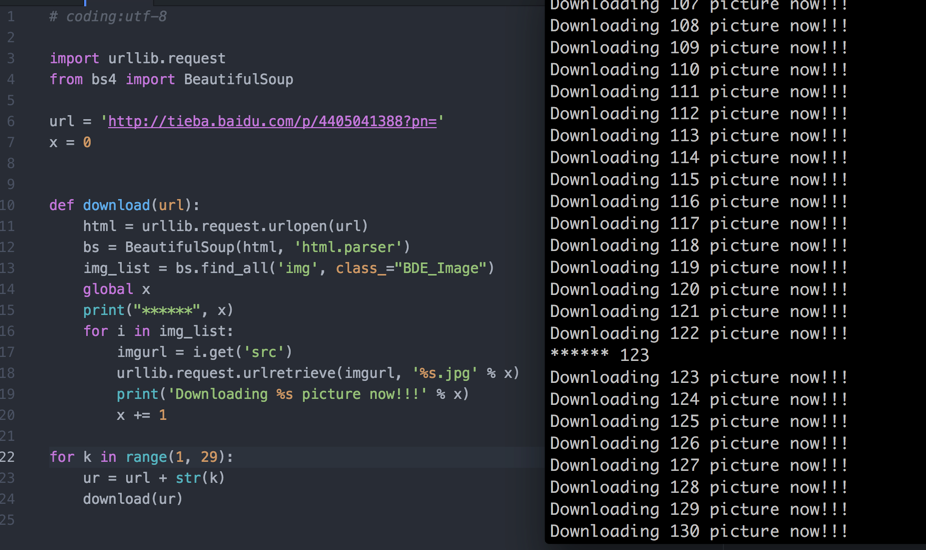

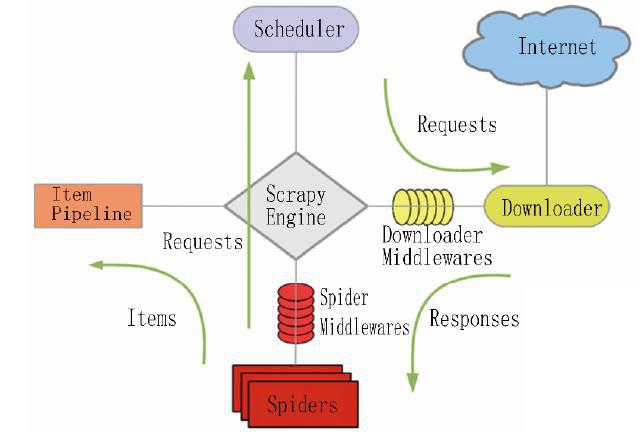

四、常用的爬虫技术

- 定向爬虫:这是最常见的一种方式,即设定一个明确的爬取目标(如特定网站的数据),并针对该目标进行抓取。

- 通用网络爬虫:则是一个可以针对任何网页的爬虫程序,通过使用一些高级算法和技术来实现更为智能的抓取。

五、面临的挑战与解决方案

虽然爬数据可以带来许多便利,但也面临着许多挑战。如网站的反爬机制、数据结构的变化、网络环境的波动等都会影响爬虫的效果。对此,我们需要采取一些策略来应对,如设置合适的抓取频率、模拟人类行为进行操作、使用代理IP等。

六、结语

随着技术的发展和互联网的普及,爬数据技术变得越来越重要。在未来的发展中,我们需要更好地利用这项技术来获取更多的信息,同时也需要关注数据的隐私和安全问题,做到合法合规地获取和使用数据。

以上就是关于爬数据的简单介绍和解析,希望对你有所帮助。如果你对这方面有更深入的兴趣或问题,欢迎随时向我提问或进行交流。