cache是什么

一、什么是cache?

定义与概念

Cache,通常被称为缓存,是一个计算机术语,主要用于在存储器中临时存储数据。它是为了提升数据访问速度而存在的一种计算机架构组件。在计算机科学中,缓存被广泛用于各种场景,包括但不限于CPU、内存、硬盘等存储设备之间的数据交换。

工作原理

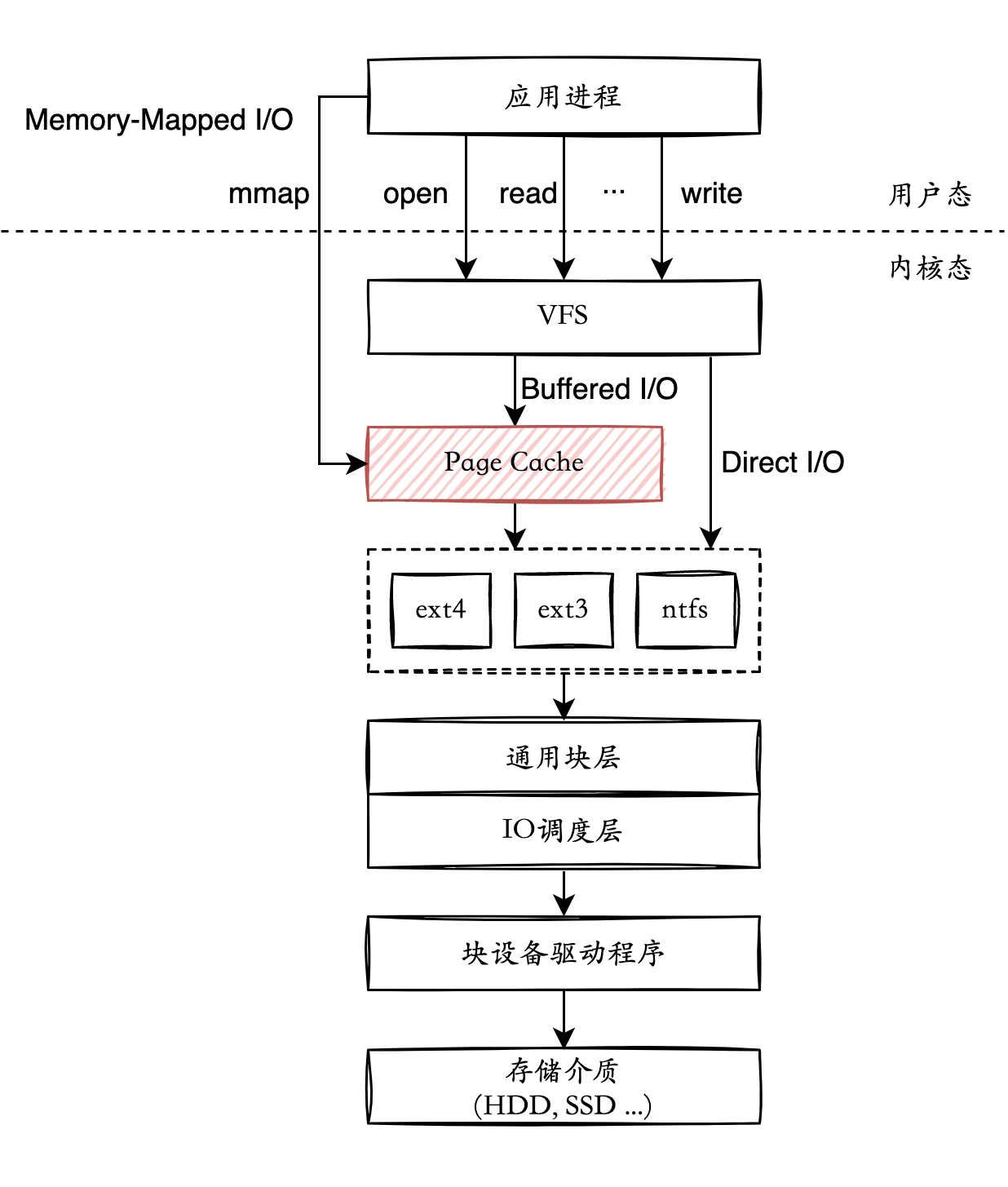

当程序或用户请求数据时,首先会尝试从缓存中获取。如果缓存中存在所需的数据,那么系统可以直接从缓存中读取数据,而无需从慢速的存储设备(如硬盘)中读取。如果缓存中没有所需的数据,那么系统会从主存储器(如内存)或外部存储器(如硬盘)中读取数据,并将其存入缓存中,以便后续的快速访问。

二、cache的种类与用途

1. 硬件级缓存

硬件级缓存主要存在于CPU、内存等硬件设备中。例如,CPU的L1、L2、L3缓存就是为了提高数据处理速度而设计的。

2. 软件级缓存

软件级缓存则是由操作系统或应用程序实现的。例如,浏览器会将用户经常访问的网页内容存入缓存中,以便下次快速打开。

3. 网络缓存

在计算机网络中,为了减轻网络带宽的压力,很多服务都支持了CDN(内容分发网络)或使用缓存服务器进行数据传输的加速。这可以有效提高网络的访问速度和稳定性。

三、Cache的作用和意义

在数字技术领域,Cache发挥着极其重要的作用。首先,它可以极大地提高数据访问速度和程序执行效率;其次,它也可以有效减少主存储器和外部存储器的访问次数和访问延迟;最后,对于提升整个系统的性能和用户体验都至关重要。

总之,cache是一种有效的数据存储和交换技术,广泛应用于各种计算机系统中。它不仅可以提高数据访问速度和程序执行效率,还可以优化整个系统的性能和用户体验。对于计算机科学领域来说,cache是一个不可或缺的重要概念。

以上就是关于cache的简单介绍,希望能够为您提供一定的参考意义。当然,在实际的应用过程中,还需要更加深入的了解和研究。如有更多需求,请查阅相关资料进行详细了解。